そこにアイは

(2025.08.23)

”そこにアイはあるんか?”というフレーズが使われるテレビCMがあります。毎回、意表をついた場面でこの言葉が出てくるので、みごとに頭に刷り込まれます。

この言葉をそのまま”AI”とすれば同じように通じる点も、日本語の面白さです。

最近では科学技術の世界でも”そこにAIはあるんか?”と自問自答しなければいけなくなりました。

●経済産業省の研究会

8月19日に経産省において「AI利活用における民事責任の在り方に関する研究会」第1回が開催されました。

https://www.meti.go.jp/shingikai/mono_info_service/ai_utilization_civil/001.html

●AIの責任

新しい「技術」が世の中に出現して、その恩恵を「人間」が受ける、あるいは「人間」がその技術を使うという図式があります。自動車も、コンピューターも同様です。

すでに経産省はAIを利用しようとする事業者に対して、2024年4月にガイドラインを発行しました[2]。このガイドラインは2016年頃から総務省・経産省で議論されてきたAI利用の手引書類を統合したもので、

”関係者による自主的な取組を促し、非拘束的なソフトローによって目的達成に導くゴールベースの考え方”

でまとめられています。

今回始まった研究会の設置について、経済産業省は、

・・・リスクが顕在化し事故が発生した際の民事責任の在り方については、AIの自律性やブラックボックス性を踏まえてどのように解釈適用を行うべきか、裁判例や統一的な見解がなく、責任の所在が不明瞭であることがシステムの導入や開発を躊躇させる一因となっている。

ことを問題視していると書いています[1]。そして、

AIを用いたサービスやシステムが事故に寄与した仮想事例を題材に、不法行為法及び製造物責任法の観点から解釈適用上の論点及び考え方の整理を行う

ことを目的としています。

まず起こりうる具体的な事例を使って思考実験をしてみようというわけです。

●AIを使う側の責任論

第1回で提示された仮想事例は次の2例です:

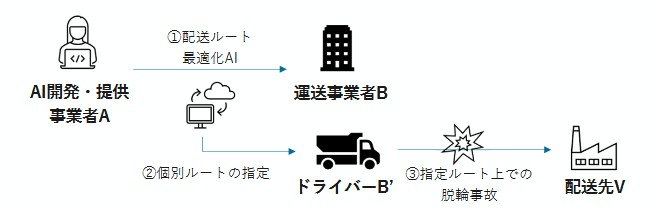

想定事例1:判断補助AI(通常業務)

開発業者Aが開発したAIシステムを、運送業者Bが使用したところ、実際の道路が狭かったため、車が脱輪して物品が破損した。

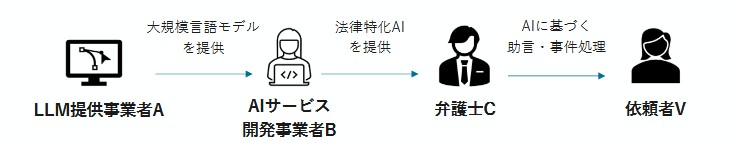

想定事例2:判断補助AI(専門業務)

大規模言語モデル(LLM)を開発した業者A、そのLLMを組み込み法律に特化したAIシステムを開発した業者B、そのAIシステムを使用した弁護士Cという関係があり、弁護士Cが検索した裁判事例を使って裁判を進めたところ敗訴となった。実はAIシステムが存在しない判例を出力していた。

どちらの事例も実際に発生する可能性が高いもので、すでに実例がいくつも出ているのではないかと思われます。

責任論の上では、あらかじめAIに関係する当事者間で責任範囲を明確にしておきたいという気持ちになるでしょう。

そして責任を明確にするために必要な証拠は何か、事前に用意できるか等がポイントになります。

●知識の有無

技術が専門的であるほど、それを開発した側と利用する側の知識の差は大きくなります。複雑な機械ならば、一般利用者が理解できる言葉で説明書が作成され、それを利用者があらかじめ読むことが前提となります。説明書が開発側と利用側との知識差を埋めて、対等な立場で契約を結ぶことができます。

これが責任範囲を決める際の基準となります。

想定事例1も想定事例2のいずれでも、この責任範囲の考え方についてはそれほど難しい問題にはならないと筆者は考えます。

もちろん現実には実行が難しい場合もあります。使用手引書をすみからすみまで読まないで、機械のスイッチを入れる人も多いでしょうし。

●日常化することによる危険性

新しい技術(ここではAI)が導入された当初は、利用者も新しい技術を不安や不信を持って見ています。しかしその利用が日常化していくにつれて、そのような疑いの目を向けることが減ります。コンピューターやインターネットから得られる情報に”嘘”や”誤り”があるということを忘れがちになります。

上の想定事例2はまさしくそのような事態です。

これからAIの利用はますます進展、拡大していくでしょう。しかし、あくまでも人間にとって有益であるべきで、害をもたらさないように常に監視している必要があります。

たいそう疲れる時代ですが、責任範囲の基準がわかりやすくはっきりしていることが助けになります。

●気の毒な先例

いろいろな事故や事件が発生して、人間と技術との関係を考えることが増えた気がします。

2019年に池袋で発生した自動車暴走事故で、運転していた高齢ドライバーが「自動車に欠陥があった」と主張しました。検証の結果、自動車の欠陥は認められず、ブレーキとアクセルの踏み間違いによる運転過失という判決に至りました。

つまり機械の側に欠陥はなく、人間の側に”ブレーキを踏んだはず”というハルシネーション(妄想)が生じていたことになります。

この事故は高齢ドライバーの問題を喚起した点で社会にも大きな影響を与えました。

自動車の自動運転が急速に普及するようになれば、ますます人間とAIの責任範囲はあいまいになってくるでしょう。

もう一つの例は、1999年に英国の郵便局において、700人以上の郵便局長らに横領や不正経理の冤罪が発生した事件です。郵便局の会計システムに障害があったため、現金額とシステムの残高に差異が生じたのが原因でした。このシステムを納入した会社は賠償責任が問われています[4]。

この事例はAIではありませんが、コンピューターの出力が誤っていたのに、人間のほうが疑われたという気の毒な例です。この例はコンピューター(あるいはAI)を無批判に使うことの危険性を示しています。(同様なケースが発生していたにもかかわらず、システムを検査しなかった英国の監査もずさんだったのではないかと筆者は思います。)

●将来の事態

これからは人手不足が原因で、文書作成もAIに任せきりになるのではないかという心配があります。人間ならば事実確認をしっかりおこなって文書を完成させるところですが、定型的な事務作業ではつい見落としも発生するでしょう。

科学の世界でも、AIに依存した安易な論文執筆や査読の問題が生じているようです。

便利になる反面、きちんと責任を果たそうとする人間にとっては負担も増していきます。

某国では公務員の人員削減が行き過ぎたため、某国の政府文書をほとんどAIが自動作成しているのではないかという冗談が笑えません。■

[1] 第1回研究会(2025年8月19日)資料2「AI利活用における民事責任の在り方に関する研究会の開催について」 https://www.meti.go.jp/shingikai/mono_info_service/ai_utilization_civil/pdf/001_02_00.pdf

[2] AI事業者ガイドライン https://www.meti.go.jp/shingikai/mono_info_service/ai_shakai_jisso/20240419_report.html

[3] 同研究会資料3「事務局説明資料」 https://www.meti.go.jp/shingikai/mono_info_service/ai_utilization_civil/pdf/001_03_00.pdf

[4] 日経新聞「英国、郵便冤罪事件の調査報告書公表へ 富士通の賠償責任焦点」(2025年7月8日) https://www.nikkei.com/article/DGXZQOGR0807Z0Y5A700C2000000/

.jpg)